Review sản phẩm

Tôi đã thấy tương lai AI của trò chơi video: nó bắt đầu bằng một nhân vật nhảy qua một hộp

Tại chương trình GTC AI của riêng mình ở San Jose, California, đầu tháng này, nhà sản xuất chip đồ họa Nvidia đã tiết lộ rất nhiều mối quan hệ đối tác và thông báo cho các sản phẩm và nền tảng AI thế hệ của nó. Đồng thời, ở San Francisco, Nvidia đã tổ chức các buổi giới thiệu ở phía sau Hội nghị nhà phát triển trò chơi Để hiển thị các nhà sản xuất trò chơi và phương tiện truyền thông làm thế nào công nghệ AI tổng quát của nó có thể làm tăng các trò chơi video trong tương lai.

Năm ngoái, Showcase GDC 2024 của NVIDIA đã có các cuộc biểu tình thực hành trong đó tôi có thể nói chuyện với các nhân vật không thể chơi được hỗ trợ AI, hoặc NPC, trong các cuộc trò chuyện giả. Họ đã trả lời những thứ tôi gõ, với các phản hồi theo ngữ cảnh hợp lý (mặc dù không hoàn toàn tự nhiên như những thứ kịch bản). AI cũng hiện đại hóa hoàn toàn các trò chơi cũ cho một cái nhìn đồ họa đương đại.

Năm nay, tại GDC 2025, NVIDIA một lần nữa mời các thành viên trong ngành và nhấn vào một phòng khách sạn gần Trung tâm Moscone, nơi tổ chức hội nghị. Trong một căn phòng lớn được gắn với các giàn máy tính được đóng gói với GPU GEFORCE 5070, 5080 và 5090 mới nhất của nó, công ty đã thể hiện nhiều cách game thủ có thể thấy AI phát triển các trò chơi cũ, cung cấp các tùy chọn mới cho các nhà làm phim hoạt hình và phát triển các tương tác NPC.

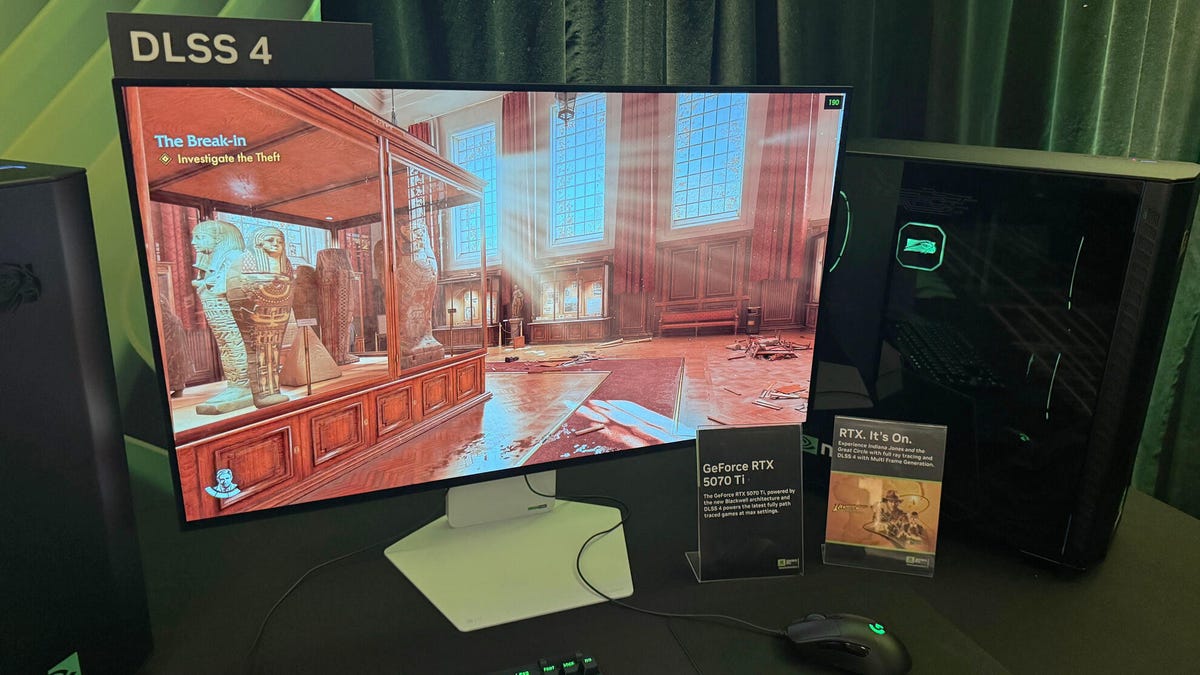

NVIDIA cũng chứng minh làm thế nào công nghệ kết xuất đồ họa AI mới nhất của mình, DLSS 4 cho dòng GPU của mình, cải thiện chất lượng hình ảnh, đường dẫn ánh sáng và khung hình trong các trò chơi hiện đại, các tính năng ảnh hưởng đến game thủ mỗi ngày, mặc dù những nỗ lực này của NVIDIA là thông thường hơn so với các thí nghiệm khác. Mặc dù một số tiến bộ này dựa vào các hãng phim để triển khai công nghệ mới vào các trò chơi của họ, những người khác hiện có sẵn để các game thủ thử.

Tạo hình ảnh động từ lời nhắc văn bản

NVIDIA đã trình bày chi tiết một công cụ mới tạo ra các hình ảnh động mô hình nhân vật dựa trên lời nhắc văn bản – giống như nếu bạn có thể sử dụng chatgpt trong imovie để làm cho các nhân vật của trò chơi của bạn di chuyển trong hành động theo kịch bản. Mục tiêu? Tiết kiệm thời gian của nhà phát triển. Sử dụng công cụ có thể biến lập trình một chuỗi vài giờ thành một nhiệm vụ vài phút.

Chuyển động cơ thể, như công cụ được gọi, có thể được cắm vào nhiều nền tảng tạo nội dung kỹ thuật số; Giám đốc sản phẩm cao cấp của Nvidia John Malaska, người điều hành bản demo của tôi, đã sử dụng Autodesk Maya. Để bắt đầu cuộc biểu tình, Malaska đã thiết lập một tình huống mẫu trong đó anh ta muốn một nhân vật nhảy qua một hộp, đất và tiến về phía trước. Trên dòng thời gian cho hiện trường, anh đã chọn khoảnh khắc cho mỗi trong ba hành động đó và viết lời nhắc văn bản để phần mềm tạo ra hình ảnh động. Sau đó, đó là thời gian để tinker.

Để tinh chỉnh hoạt hình của mình, anh ta đã sử dụng chuyển động cơ thể để tạo ra bốn biến thể khác nhau của nhân vật nhảy và chọn một trong những người anh ta muốn. (Tất cả các hình ảnh động được tạo ra từ dữ liệu chụp chuyển động được cấp phép, Malaska nói.) Sau đó, anh ta chỉ định nơi chính xác anh ta muốn nhân vật hạ cánh, và sau đó chọn nơi anh ta muốn chúng kết thúc. Chuyển động cơ thể mô phỏng tất cả các khung ở giữa những điểm xoay chuyển động được lựa chọn cẩn thận và phân đoạn Boom: Animation đạt được.

Trong phần tiếp theo của bản demo, Malaska có cùng một nhân vật đi qua một đài phun nước để đến một bộ cầu thang. Anh ta có thể chỉnh sửa với lời nhắc văn bản và điểm đánh dấu dòng thời gian để nhân vật lén lút và phá vỡ các đồ đạc trong sân.

“Chúng tôi rất vui mừng về điều này,” Malaska nói. “Nó thực sự sẽ giúp mọi người tăng tốc và tăng tốc quy trình công việc.”

Anh ta chỉ ra các tình huống mà một nhà phát triển có thể nhận được một hình ảnh động nhưng muốn nó chạy hơi khác nhau và gửi lại cho các nhà làm phim hoạt hình để chỉnh sửa. Một kịch bản tốn nhiều thời gian hơn nhiều sẽ là nếu các hoạt hình dựa trên việc bắt giữ chuyển động thực tế và nếu trò chơi yêu cầu sự trung thành như vậy, việc đưa các diễn viên MOCAP trở lại ghi lại có thể mất nhiều ngày, vài tuần hoặc vài tháng. Điều chỉnh hình ảnh động với chuyển động cơ thể dựa trên thư viện dữ liệu chụp chuyển động có thể phá vỡ tất cả những điều đó.

Tôi sẽ không lo lắng cho các nghệ sĩ bắt giữ chuyển động và liệu chuyển động cơ thể có thể được sử dụng để phá vỡ công việc của họ một phần hay toàn bộ. Một cách hào phóng, công cụ này có thể được sử dụng tốt để làm cho hoạt hình và các chuỗi gần như phân tích trước khi đưa các nghệ sĩ chuyên nghiệp vào các cảnh hoàn thành chuyển động. Nhưng giống như bất kỳ công cụ nào, tất cả phụ thuộc vào người đang sử dụng nó.

Body Motion dự kiến sẽ được phát hành sau đó vào năm 2025 theo giấy phép của NVIDIA Enterprise.

Một cú đâm khác tại Remastering Half-Life 2 bằng cách sử dụng RTX Remix

Tại GDC năm ngoái, tôi đã thấy một số bản làm lại của Half-Life 2 với nền tảng của NVIDIA cho Modder, RTX Remix, có nghĩa là để hít thở cuộc sống mới vào các trò chơi cũ. Stab mới nhất của Nvidia tại Reviving Valve's Classic Game đã được phát hành ra công chúng dưới dạng bản demo miễn phí, mà các game thủ có thể tải xuống trên Steam để tự kiểm tra. Những gì tôi đã thấy về nó trong phòng báo chí của Nvidia cuối cùng là một bản demo công nghệ (chứ không phải toàn bộ trò chơi), nhưng nó vẫn thể hiện những gì RTX Remix có thể làm để cập nhật các trò chơi cũ để đáp ứng kỳ vọng đồ họa hiện đại.

Cuộc biểu tình của RTX Remix Remix 2 năm ngoái là về việc xem kết cấu tường phẳng, có thể được cập nhật với các hiệu ứng chiều sâu như thế nào, làm cho chúng trông giống như đá cuội được vữa, và điều đó cũng có mặt ở đây. Khi nhìn vào một bức tường, “những viên gạch dường như xuất hiện vì họ sử dụng bản đồ chéo Parallax”, Nyle Usmani, giám đốc sản phẩm cao cấp của RTX Remix, người đã lãnh đạo bản demo cho biết. Nhưng bản demo năm nay là nhiều hơn về sự tương tác ánh sáng – ngay cả đến mức mô phỏng bóng đi qua kính bao phủ mặt số của máy đo khí.

Usmani dẫn tôi qua tất cả các hiệu ứng ánh sáng và lửa, nơi hiện đại hóa một số phần ám ảnh mang tính biểu tượng hơn của khu vực Ravenholm rơi của Half-Life 2. Nhưng ứng dụng nổi bật nhất là ở một khu vực mà kẻ thù Headcrab mang tính biểu tượng tấn công, khi Usmani dừng lại và chỉ ra rằng đèn nền được lọc qua các phần thịt của các giả giả kỳ cục, khiến chúng phát sáng màu đỏ mờ, giống như những gì xảy ra khi bạn đặt một ngón tay lên phía trước đèn pin. Trùng hợp với GDC, NVIDIA đã phát hành hiệu ứng này, được gọi là tán xạ dưới bề mặt, trong bộ dụng cụ phát triển phần mềm để các nhà phát triển trò chơi có thể bắt đầu sử dụng nó.

RTX Remix có các thủ thuật khác mà Usmani chỉ ra, giống như một shader thần kinh mới cho phiên bản mới nhất của nền tảng-bản demo trong Half-Life 2. Về cơ bản, ông giải thích, một loạt các mạng lưới thần kinh đào tạo trực tiếp trên dữ liệu trò chơi khi bạn chơi và điều chỉnh ánh sáng gián tiếp theo những gì người chơi nhìn thấy, làm cho các khu vực được thắp sáng giống như chúng trong cuộc sống thực. Trong một ví dụ, anh ta đã hoán đổi giữa các phiên bản RTX RTX cũ và mới, hiển thị, trong phiên bản mới, ánh sáng lọc đúng cách qua các bè bị hỏng của một nhà để xe. Vẫn tốt hơn, nó va vào các khung hình mỗi giây đến 100, tăng từ 87.

“Theo truyền thống, chúng tôi sẽ theo dõi một tia và nảy nó nhiều lần để chiếu sáng một căn phòng,” Usmani nói. “Bây giờ chúng tôi theo dõi một tia và nảy nó chỉ hai đến ba lần và sau đó chúng tôi chấm dứt nó, và AI tạo ra vô số phần nảy sau đó. Trên đủ khung hình, nó gần giống như nó tính toán một số lượng vô hạn, vì vậy chúng tôi có thể có được độ chính xác hơn vì nó sẽ tăng thêm hiệu suất.”

Tuy nhiên, tôi đã thấy bản demo trên GPU RTX 5070, bán lẻ với giá 550 đô la và bản demo yêu cầu ít nhất RTX 3060 TI, vì vậy chủ sở hữu card đồ họa cũ hơn so với may mắn. “Đó hoàn toàn là vì truy tìm đường dẫn rất tốn kém – ý tôi là, đó là tương lai, về cơ bản là tiên tiến và đó là dấu vết đường dẫn tiên tiến nhất”, Usmani nói.

Nvidia ace sử dụng AI để giúp NPC nghĩ

Trạm AI NPC AI năm ngoái đã chứng minh cách các nhân vật không chơi có thể phản ứng duy nhất với người chơi, nhưng NVIDIA ACE Tech năm nay đã cho thấy cách người chơi có thể đề xuất những suy nghĩ mới cho các NPC sẽ thay đổi hành vi của họ và cuộc sống xung quanh họ.

Nhà sản xuất GPU đã chứng minh công nghệ được cắm vào Inzoi, một trò chơi giống như Sims, nơi người chơi chăm sóc các NPC với hành vi của riêng họ. Nhưng với một bản cập nhật sắp tới, người chơi có thể chuyển đổi trên Smart Zoi, nơi sử dụng Nvidia Ace để chèn những suy nghĩ trực tiếp vào tâm trí của Zois (nhân vật) mà họ giám sát … và sau đó xem họ phản ứng tương ứng. Những suy nghĩ này không thể đi ngược lại những đặc điểm của riêng họ, nhà phân tích tiếp thị công nghệ Nvidia Geforce Wynne Riawan giải thích, vì vậy họ sẽ gửi ZOI theo hướng có ý nghĩa.

“Vì vậy, bằng cách khuyến khích họ, ví dụ, 'Tôi muốn làm cho ngày của mọi người cảm thấy tốt hơn”, nó sẽ khuyến khích họ nói chuyện với nhiều zois xung quanh họ “, Riawan nói.” Hãy thử là từ khóa: họ vẫn thất bại. Họ giống như con người. ”

Riawan đưa một suy nghĩ vào đầu Zoi: “Nếu tôi chỉ là một AI trong một mô phỏng thì sao?” Zoi tội nghiệp hoảng sợ nhưng vẫn chạy đến phòng tắm công cộng để đánh răng, phù hợp với những đặc điểm của cô, rõ ràng, thực sự thích vệ sinh răng miệng.

Những hành động NPC này theo dõi những suy nghĩ được chú ý của người chơi được cung cấp bởi một mô hình ngôn ngữ nhỏ với nửa tỷ tham số (các mô hình ngôn ngữ lớn có thể đi từ 1 tỷ đến hơn 30 tỷ thông số, với cơ hội cao hơn cho các phản hồi sắc thái). Một trong những trò chơi được sử dụng dựa trên mô hình Minitron Nemo Nemo 8 tỷ tham số được thu hẹp xuống để có thể được sử dụng bởi GPU cũ và ít mạnh mẽ hơn.

“Chúng tôi cố tình làm giảm mô hình thành một mô hình nhỏ hơn để có thể truy cập được nhiều người hơn”, Riawan nói.

NVIDIA ACE Tech chạy trên thiết bị bằng cách sử dụng GPU máy tính-Krafton, nhà xuất bản phía sau Inzoi, đề xuất một thông số GPU tối thiểu của NVIDIA RTX 3060 với bộ nhớ ảo 8GB để sử dụng tính năng này, Riawan nói. Krafton đã cho Nvidia một “ngân sách” của một gigabyte của VRAM để đảm bảo card đồ họa có đủ tài nguyên để hiển thị, tốt, đồ họa. Do đó cần phải giảm thiểu các tham số.

NVIDIA vẫn đang thảo luận nội bộ về cách thức hoặc có mở khóa khả năng sử dụng các mô hình ngôn ngữ tham số lớn hơn hay không nếu người chơi có GPU mạnh hơn. Người chơi có thể thấy sự khác biệt, vì NPC “phản ứng linh hoạt hơn khi họ phản ứng tốt hơn với môi trường xung quanh bạn với một mô hình lớn hơn”, Riawan nói. “Ngay bây giờ, với điều này, sự nhấn mạnh chủ yếu là vào suy nghĩ và cảm xúc của họ.”

Một phiên bản truy cập sớm của tính năng Smart Zoi sẽ được dành cho tất cả người dùng miễn phí, bắt đầu từ ngày 28 tháng 3.

“Nếu bạn có MMORPG với nvidia ace trong đó, NPC sẽ không bị trì trệ và chỉ tiếp tục lặp lại cùng một cuộc đối thoại – họ có thể năng động hơn và tạo ra phản hồi của chính họ dựa trên danh tiếng của bạn hoặc một cái gì đó.

Xem cái này: Mọi thứ được công bố tại sự kiện CES của NVIDIA trong 12 phút

Khám phá thêm từ Phụ Kiện Đỉnh

Đăng ký để nhận các bài đăng mới nhất được gửi đến email của bạn.