Review sản phẩm

Chip Enfabrica 3,2 Tbps ACF SuperNIC: Tăng cường hiệu suất và độ tin cậy của trung tâm dữ liệu AI cho quy mô cụm AI lớn

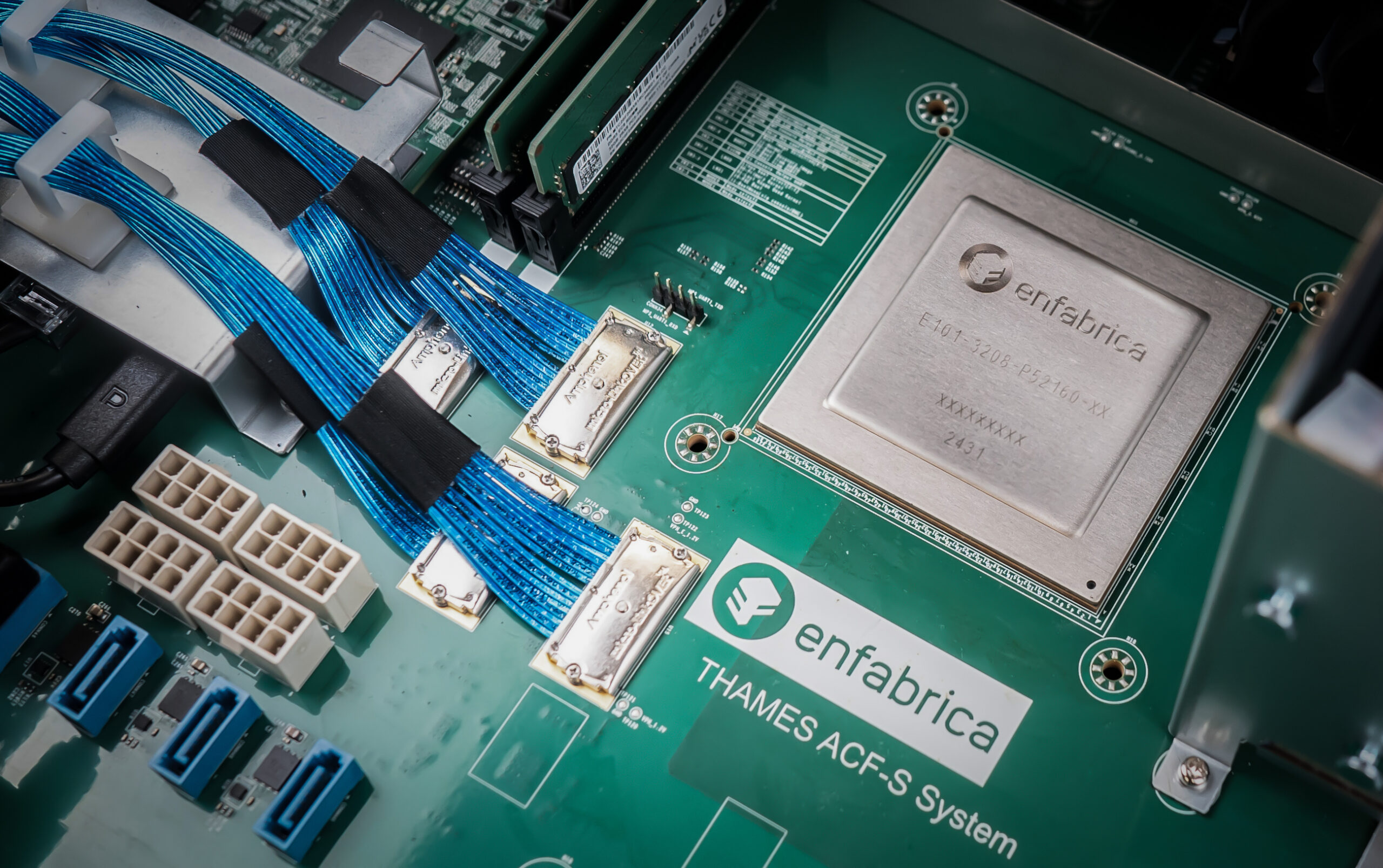

Tại Siêu máy tính 2024 (SC24), Tập đoàn Enfabrica công bố một cột mốc quan trọng trong mạng trung tâm dữ liệu AI: Vải điện toán tăng tốc (ACF) SuperNIC chip. Cái này 3.2 SoC Card giao diện mạng (NIC) Terabit/giây (Tbps) xác định lại các hoạt động AI và máy học (ML) quy mô lớn bằng cách cho phép khả năng mở rộng lớn, hỗ trợ các cụm trên 500.000 GPU. Enfabrica cũng nâng cao 115 triệu USD tài trợ và dự kiến sẽ phát hành (ACF) SuperNIC chip vào Quý 1 năm 2025.

Giải quyết các thách thức về mạng AI

Khi các mô hình AI ngày càng phát triển lớn mạnh và phức tạp, các trung tâm dữ liệu phải đối mặt với áp lực ngày càng tăng trong việc kết nối số lượng lớn các đơn vị xử lý chuyên dụng, chẳng hạn như GPU. Những GPU này rất quan trọng để tính toán tốc độ cao trong đào tạo và suy luận nhưng thường không hoạt động do di chuyển dữ liệu không hiệu quả trên các kiến trúc mạng hiện có. Thách thức nằm ở việc kết nối hiệu quả hàng nghìn GPU để đảm bảo truyền dữ liệu tối ưu mà không bị tắc nghẽn hoặc suy giảm hiệu suất.

Các phương pháp kết nối mạng truyền thống có thể liên kết khoảng 100.000 chip điện toán AI trong trung tâm dữ liệu trước khi tình trạng kém hiệu quả và chậm chạp trở nên nghiêm trọng. Theo Giám đốc điều hành của Enfabrica, Rochan Sankar, công nghệ mới của công ty hỗ trợ tới 500.000 chip trong một hệ thống AI/ML duy nhất, cho phép tính toán mô hình AI lớn hơn và đáng tin cậy hơn. Bằng cách khắc phục những hạn chế của thiết kế NIC thông thường, ACF SuperNIC của Enfabrica tối đa hóa việc sử dụng GPU và giảm thiểu thời gian ngừng hoạt động.

Những đổi mới quan trọng trong ACF SuperNIC

ACF SuperNIC tự hào có một số tính năng đầu tiên trong ngành phù hợp với nhu cầu của trung tâm dữ liệu AI hiện đại:

- Kết nối đa cổng, băng thông cao: ACF SuperNIC cung cấp Ethernet 800 Gigabit nhiều cổng cho các máy chủ GPU, tăng gấp bốn lần băng thông so với các NIC gắn GPU khác. Thiết lập này cung cấp thông lượng chưa từng có và nâng cao khả năng phục hồi đa đường, đảm bảo khả năng liên lạc mạnh mẽ giữa các cụm AI.

- Thiết kế mạng hai tầng hiệu quả: Với cấu hình cơ số cao gồm 32 cổng mạng và lên tới 160 làn PCIe, ACF SuperNIC đơn giản hóa kiến trúc tổng thể của trung tâm dữ liệu AI. Hiệu quả này cho phép các nhà khai thác xây dựng các cụm lớn sử dụng ít tầng hơn, giảm độ trễ và cải thiện hiệu quả truyền dữ liệu trên các GPU.

- Mở rộng quy mô và mở rộng quy mô: Enfabrica ACF SuperNIC, với cơ số cao, băng thông cao và khả năng di chuyển dữ liệu và đa đường PCIe/Ethernet đồng thời, có thể mở rộng quy mô một cách độc đáo và mở rộng quy mô từ bốn đến tám GPU thế hệ mới nhất cho mỗi hệ thống máy chủ. Điều này làm tăng đáng kể hiệu suất, quy mô và khả năng phục hồi của cụm AI, đảm bảo sử dụng tài nguyên tối ưu và hiệu quả mạng.

- Giao diện PCIe tích hợp: Chip hỗ trợ 128 đến 160 làn PCIe, cung cấp tốc độ trên 5 Tbps. Thiết kế này cho phép nhiều GPU kết nối với một CPU duy nhất trong khi vẫn duy trì liên lạc tốc độ cao với các thiết bị chuyển mạch cột sống của trung tâm dữ liệu. Kết quả là một bố cục hiệu quả và linh hoạt hơn có thể hỗ trợ khối lượng công việc AI quy mô lớn.

- Đa đường tin nhắn linh hoạt (RMM): Công nghệ RMM độc quyền của Enfabrica tăng cường độ tin cậy của cụm AI. Bằng cách giảm thiểu tác động của lỗi hoặc sự cố liên kết mạng, RMM ngăn ngừa tình trạng đình trệ công việc, đảm bảo quá trình đào tạo AI mượt mà và hiệu quả hơn. Sankar lưu ý tầm quan trọng của tính năng này, đặc biệt là trong các thiết lập lớn, nơi thường xuyên xảy ra lỗi liên kết đến bộ chuyển mạch.

- Mạng RDMA được xác định bằng phần mềm: Tính năng độc đáo này trao quyền cho các nhà khai thác trung tâm dữ liệu khả năng lập trình và gỡ lỗi toàn diện, mang lại lợi ích của mạng được xác định bằng phần mềm (SDN) vào Truy cập bộ nhớ trực tiếp từ xa (RDMA) thiết lập. Nó cho phép tùy chỉnh lớp vận chuyển, có thể tối ưu hóa cấu trúc liên kết mạng quy mô đám mây mà không làm giảm hiệu suất.

Tăng cường khả năng phục hồi và hiệu quả

Các hệ thống truyền thống thường yêu cầu kết nối một-một giữa GPU và các thành phần khác nhau, chẳng hạn như bộ chuyển mạch PCIe và NIC RDMA. Tuy nhiên, theo Shankar, khi số lượng GPU trong hệ thống tăng lên, nguy cơ lỗi liên kết đến các bộ chuyển mạch sẽ tăng lên, với khả năng gián đoạn có thể xảy ra thường xuyên cứ sau 23 phút trong các thiết lập có hơn 100.000 GPU.

ACF SuperNIC giải quyết vấn đề này bằng cách cho phép nhiều kết nối từ GPU đến bộ chuyển mạch. Sự dư thừa này giảm thiểu tác động của các lỗi thành phần riêng lẻ, tăng thời gian hoạt động và độ tin cậy của hệ thống.

SuperNIC cũng giới thiệu Tính năng phân vùng bộ nhớ tập thểhỗ trợ truyền dữ liệu không sao chép và tối ưu hóa việc quản lý bộ nhớ máy chủ. Bằng cách giảm độ trễ và nâng cao hiệu quả bộ nhớ, công nghệ này tối đa hóa phép tính dấu phẩy động mỗi giây (FLOP) việc sử dụng đội máy chủ GPU.

Khả năng mở rộng và lợi ích hoạt động

Thiết kế của ACF SuperNIC không chỉ chú trọng đến quy mô mà còn chú trọng đến hiệu quả hoạt động. Nó cung cấp một gói phần mềm tích hợp với giao tiếp tiêu chuẩn, các giao diện hiện có và các hoạt động mạng RDMA. Khả năng tương thích này đảm bảo triển khai hiệu quả trên các môi trường điện toán AI đa dạng bao gồm GPU và bộ tăng tốc (chip AI) từ các nhà cung cấp khác nhau. Các nhà khai thác trung tâm dữ liệu được hưởng lợi từ cơ sở hạ tầng mạng được sắp xếp hợp lý, giảm độ phức tạp và nâng cao tính linh hoạt của trung tâm dữ liệu AI của họ.

Sự sẵn có và triển vọng trong tương lai

ACF SuperNIC của Enfabrica sẽ được cung cấp với số lượng hạn chế vào Quý 1 năm 2025, với cả chip và hệ thống thí điểm hiện đang mở cho các đơn đặt hàng thông qua Enfabrica và các đối tác được chọn. Khi các mô hình AI yêu cầu hiệu suất cao hơn và quy mô lớn hơn, cách tiếp cận đổi mới của Enfabrica có thể đóng vai trò then chốt trong việc định hình thế hệ trung tâm dữ liệu AI tiếp theo được thiết kế để hỗ trợ các mô hình Frontier AI.

Nộp vào . Đọc thêm về AI (Trí tuệ nhân tạo), Chip, AI tổng hợp, Chất bán dẫn, Máy chủ, SoC và Siêu máy tính.

Khám phá thêm từ Phụ Kiện Đỉnh

Đăng ký để nhận các bài đăng mới nhất được gửi đến email của bạn.